Entiende qué es MCP, el protocolo que promete facilitar las conexiones entre herramientas de IA y repositorios de datos externos.

Las herramientas de inteligencia artificial han revolucionado la forma en que buscamos información y resolvemos problemas complejos. Sin embargo, todavía existen algunas barreras para el uso de estas plataformas, especialmente cuando necesitamos lidiar con datos privados o creados en tiempo real. Sin embargo, esto puede ser fácilmente resuelto utilizando el MCP para integrar la IA generativa a los repositorios de información.

El MCP es un protocolo creado por Anthropic que permite la conexión entre grandes modelos de lenguaje (LLMs) a servidores externos de manera estandarizada. Esta tecnología promete revolucionar la forma en que usamos la inteligencia artificial en el día a día.

Sin embargo, el MCP todavía presenta algunas limitaciones y necesita supervisión humana para la ejecución de ciertas tareas. Continúa leyendo para saber más sobre este protocolo y descubre también cómo usarlo en la práctica.

¿Qué es MCP y por qué es importante?

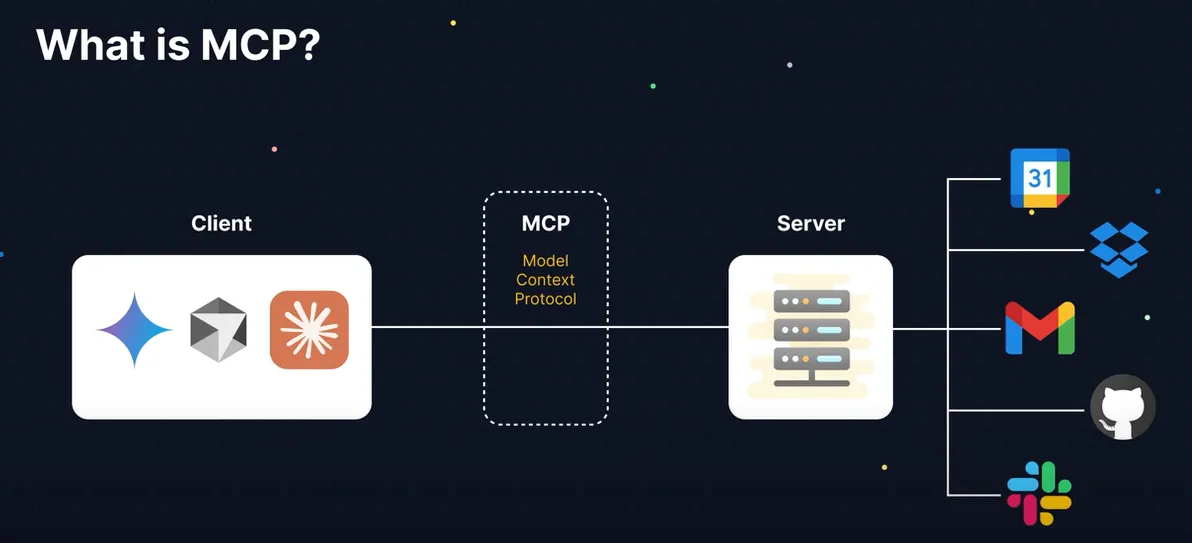

MCP es el acrónimo de Model Context Protocol, se trata de un protocolo abierto cuyo objetivo es ser un conector universal entre las LLMs y los repositorios donde se encuentran las informaciones relevantes para el usuario, como bases de datos, entornos de desarrollo y plataformas como Google Drive y GitHub.

Antes del lanzamiento de esta tecnología, ya era posible hacer este tipo de conexión. Sin embargo, el proceso para conectar la IA generativa al servidor externo requería la creación de un camino específico entre la herramienta de inteligencia artificial y el lugar donde se almacenaban la información, lo que hacía el procedimiento más lento, laborioso y propenso a fallos.

Existen dos tipos de MCP, uno de ellos es el SSE, que se basa en HTTP para servidores MCP remotos.

Ya el otro es el MCP STDIO, que se basa en flujos de entrada y salida del propio sistema operativo, que realiza la integración local de componentes en el mismo sistema.

Definición de MCP y su papel en los sistemas de IA generativa

El MCP fue desarrollado para servir como un puente universal entre las LLMs y los servidores externos, eliminando la necesidad de tener conectores específicos para cada fuente de datos.

Para utilizarlo, simplemente configure un servidor MCP en la IA generativa y en cada repositorio externo. Así, cuando el usuario haga una solicitud, la herramienta buscará información en los servidores externos para ofrecer una respuesta más precisa y eficiente.

Ventajas del uso del MCP

Con el Protocolo de Contexto de Modelo, es posible estandarizar todas las conexiones entre las herramientas de inteligencia artificial y los repositorios externos, sin que sea necesario desarrollar nuevos caminos cada vez que se necesite hacer una nueva integración.

Otra ventaja es que este protocolo es compatible con entornos distintos, como servidores locales, en la nube o híbridos. Esta funcionalidad permite que diferentes tipos de sistema trabajen de manera conjunta, lo que es esencial para quien quiere o necesita escalar las operaciones y para aquellos que necesitan dar soporte a múltiples clientes.

Además, todos los datos intercambiados entre LLM y los servidores externos utilizan el formato estructurado basado en JSON-RPC 2.0, permitiendo, de esta manera, que las tecnologías utilicen la misma estructura para comunicarse, independientemente del lenguaje de programación utilizado para desarrollarlas.

¿En qué se diferencia el MCP de otras integraciones?

La diferencia entre el MCP y las otras tecnologías de integración es que utiliza un protocolo único y universal para hacer todas las conexiones, diferente a las otras opciones disponibles hoy.

¿Cómo funciona el MCP?

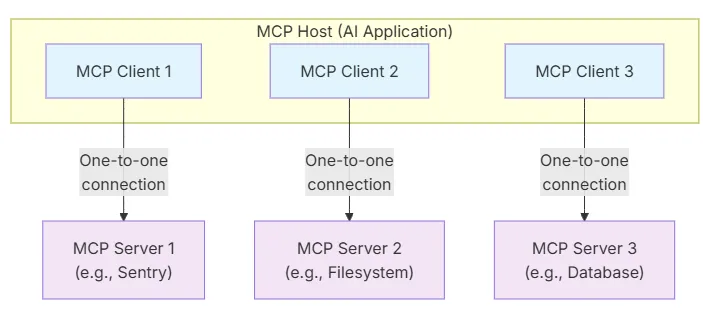

Este protocolo sigue la arquitectura cliente-servidor, la cual puede ser ejemplificada de la siguiente manera:

- Host MCP: asistente de IA que gestiona uno o más servidores MCP;

- Cliente MCP: componente que mantiene la conexión entre el servidor y el host MCP;

- Servidor MCP: estructura responsable de proporcionar contexto a los clientes MCP.

¿Cuáles son los elementos del Protocolo de Contexto de Modelo?

Para funcionar de la manera esperada, este protocolo cuenta con los siguientes elementos:

- Especificación MCP: describe los requisitos de implementación para clientes y servidores;

- MCP SDKs: proporciona SDKs para diferentes lenguajes de programación;

- Herramientas de desarrollo: recursos para el desarrollo de servidores y clientes MCP.

Para qué sirve el MCP en la práctica

Ahora que ya sabes qué es MCP y cuál es la diferencia entre este protocolo y las otras formas de conectar las LLMs a bases de datos externas, descubre para qué sirve en la práctica y cómo puede facilitar el día a día de diferentes profesionales.

Casos de uso más comunes

El Model Context Protocol puede ser utilizado de innumerables maneras y contextos. Uno de los más obvios es en la atención al cliente. Puedes usar esta tecnología para integrar el chatbot a todas las bases que contengan información sobre los consumidores, como CRMs y bases de datos con información de pedidos y pagos.

Al acceder a esta información, el asistente virtual será capaz de ofrecer un servicio más personalizado y estará más capacitado para resolver la demanda del cliente.

Otro ejemplo de uso común es en el desarrollo de software. Esto es porque es posible usar el protocolo para conectar la IA generativa a repositorios en GitHub y también a bases de datos que contengan la información necesaria para la creación de las aplicaciones.

Profesionales que necesitan tomar decisiones basadas en datos en tiempo real, como consultores financieros, pueden usar el protocolo para integrar la LLM a repositorios que contengan información actualizada sobre el rendimiento de las acciones.

Cómo están utilizando el MCP empresas como OpenAI, Anthropic, Replit y otras

Anthropic es la empresa responsable del desarrollo del Protocolo de Modelo de Contexto, creado para facilitar la conexión entre los asistentes de IA y la información necesaria para realizar las tareas propuestas de una manera más personalizada y fundamentada.

A principios de 2025, OpenAI inició las pruebas de una nueva función llamada “Trabajar con Aplicaciones”, la cual permite que ChatGPT se conecte directamente a algunas aplicaciones de programación utilizando este protocolo.

Otra compañía que comenzó a utilizar el MCP es Replit, una plataforma de desarrollo de aplicaciones. Usando el Model Context Protocol, es posible integrar esta herramienta a repositorios externos para facilitar la creación de sistemas más personalizados y eficientes.

Incluso Microsoft comenzó a utilizar MCP para conectar asistentes de Inteligencia Artificial, como Copilot Studio, con herramientas y bases de datos externas. Los usuarios de estas plataformas pueden utilizar esta integración para solicitar que LLM acceda a sus repositorios y realice acciones como programar citas en la agenda y redactar o resumir correos electrónicos.

Cómo hacer la integración del MCP en n8n

El Model Context Protocol (MCP) ha estado llamando la atención de aquellos que trabajan con automatización e IA porque ofrece un “estándar universal” para conectar modelos de lenguaje con datos y herramientas. En el caso de n8n, esto significa abrir el camino para flujos aún más inteligentes: como buscar información en APIs externas, cruzarla con datos internos y entregar respuestas listas para la acción.

Para aprovechar esta integración, es importante ya tener un ambiente preparado:

- Servidor actualizado (preferentemente Node 20+ y Docker).

- Aislamiento y seguridad en n8n, especialmente al usar Nodos Comunitarios.

- Configuración segura en el transporte (STDIO o SSE con autenticación y TLS).

Si quieres conocer el paso a paso técnico, con código e instrucciones detalladas, no necesitas reinventar la rueda. Hay una excelente guía oficial — en inglés — que muestra cómo construir un servidor MCP y conectarlo a n8n, cubriendo desde la configuración hasta ejemplos de uso práctico. Consulta el Tutorial oficial para crear e integrar un servidor MCP

Y si quieres ir directamente a la práctica, HostGator ya ofrece VPS con n8n instalado, listo para que integres el MCP y crees flujos de automatización avanzados con seguridad, alto rendimiento y total libertad de configuración. Preguntar al ChatGPT

Seguridad y buenas prácticas con MCP

A pesar de que el Model Context Protocol innova la forma de usar las LLMs, es necesario tomar algunas precauciones al usar el protocolo, conozca ahora cuáles son las principales.

Riesgos y vulnerabilidades comunes

El MCP es relativamente simple de implementar. Sin embargo, si el proceso de implementación no se realiza de la manera correcta, la seguridad de los datos contenidos en los repositorios puede estar en riesgo.

Entre los principales riesgos que pueden ocurrir debido a una mala implementación de la tecnología están:

- Exposición de datos sensibles.

- Ejecución de códigos maliciosos.

- Ataques de inyección de prompts.

Cómo mitigar los riesgos

Aunque puede haber algunos riesgos en la implementación del protocolo, es posible mitigar estos peligros. A continuación, descubre cómo hacerlo.

- Incluir patrones de autenticación, como OAuth

- Ejecutar un control de permisos riguroso

- Programar emisiones de alertas en caso de abuso o manipulación

- Realizar auditorías regularmente.

Además, para la ejecución de algunas tareas, la propia Anthropic recomienda que haya supervisión humana, especialmente en casos en los que los servidores necesitan solicitar que la LLM genere una salida.

Conclusión

Usar el MCP para personalizar las integraciones entre asistentes virtuales y repositorios de datos externos es una excelente manera de estandarizar y simplificar este tipo de conexión, ya que elimina la necesidad de crear un camino específico entre la LLM y cada servidor.

Sin embargo, es necesario tomar algunas precauciones para no exponer datos sensibles o permitir que la herramienta de inteligencia artificial se utilice de manera inadecuada. Para saber más sobre las plataformas de IA que pueden revolucionar tu día a día, consulta más contenidos sobre este tema en el sitio de HostGator: